Comment résumer la plus belle conférence que nous ayons vu cette année ? IMPOSSIBLE !!

Un très bel endroit, l’institut océanographique de Paris, une excellente animation par le rédacteur en chef de 20 minutes, Laurent Bainier, des intervenants fantastiques, pour la plupart, et un contenu alliant la science, la culture, l’innovation, le yoga, la danse, … plein d’intelligences et d’émotions.

En une phrase : « l’humain, l’humain, l’humain, l’humain » à la fois dans ce qu’il a de beau, de bon, d’intéressant mais aussi de moins chouette !

En sortant de cette matinée, si nous étions un annonceur, nous aurions fait un chèque immédiatement pour une page de pub dans le titre en remerciement de l’intelligence fournie. Ne l’étant pas, nous avons foncé dans la librairie la plus proche pour dévorer les bouquins des différents intervenants ! (En oubliant le chauffage de l’institut qui avait sauté dans la nuit et dont l’absence permettait de garder des idées …fraîches)

-

L’intelligence

Gérald Bronner, sociologue (dernier livre : la déchéance de rationalité).

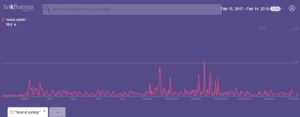

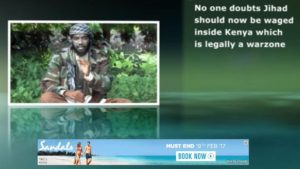

Il intervenait pour prôner ce qui est son credo en tant que sociologue, la nécessité de la rationalité. Nous vivons une époque passionnante (on est d’accord) dont une des caractéristiques est la dérégulation massive de l’information. Avant l’ère digitale, la science permettait de construire et valider des modèles intellectuels. Depuis l’avènement du digital, tout est questionné et questionnable, ce qui est une bonne chose, mais, ce n’est pas forcement, malheureusement, les arguments scientifiques, rationnels qui l’emportent ! Alors, comment aider l’humain à ne pas céder aux « conneries » qui circulent si vite (les fausses infos iraient 6 fois plus vite à circuler que les infos vérifiées sur Twitter) car elles vont dans le sens de ce qu’attend notre cerveau (sciences cognitives), comment aider les individus à faire leur indépendance mentale ? Il a beaucoup travaillé sur les rumeurs, les superstitions ou autres fausses croyances en allant des sectes (gag : les platistes, ceux qui prônent que la terre est plate ont des membres tout autour de la terre) au djihadisme. Pour lui, il n’y pas qu’un déterminisme social dans ces pensées extrêmes mais aussi un « choix » de l’individu guidé en bien et en mal par ce que l’on découvre du cerveau avec les sciences cognitives (vive l’interdisciplinarité !). Ainsi le droit au doute doit s’accompagner de devoir, en apportant des arguments fondés, le doute doit s’incliner devant la réalité.

« Il faut douter avec méthode ».

Ce n’est pas ce que font les conspirationnistes et il ne sert à rien de contester leurs croyances (cela ne fait que les renforcer) mais au contraire il faut les aider à comprendre leur façon de raisonner sur d’autres sujets (Par exemple ils confondent bien souvent corrélation et causalité). Si nous faisons le lien avec 20minutes, de l’importance des informations vérifiées, validées, argumentées !

Lauren Boudard et Dan Geiselhart : Tech, algo, IA …je t’aime moi non plus (livre : les possédés)

Ils ont fondé un collectif Tech trash qui prend du recul par rapport à la déferlante technologique. Leur slogan « bete et méchant » mais gentiment. Pour eux, il n’y a pas d’intersection entre les choix que nous faisons et nos valeurs, c’est la contradiction humaine. 2 exemples :

- le scandale cambridge analytica qui heurte nos valeurs n’empêche pas Facebook de continuer a croitre en nombre d’abonnés !

- L’utilisation de Google vs Qwant : On démarre par une recherche sur Qwant, on ne trouve pas ce que l’on cherche en moins de 10 secondes, on fait la même recherche sur Google, on a mauvaise conscience (Nous confirmons !).

Alors pourquoi l’humain fait-il cela ?

Platon nous donne la réponse c’est l’ACRASIE, le fait d’aller à l’encontre de son meilleur jugement. On voit le bien, on l’approuve mais on fait le mal… ! C’est notre intime désaccord. Un autre mot en français pour Acrasie c’est l’incontinence…

Il y a des moyens de combattre notre ACRASIE :

- en nous pre-engageant sur quelque chose (dire a d’autres ce que nous allons faire avant de le faire, nous poussera a le faire)

- avoir des intentions de mise en œuvre qui ne concerne que nous avec nous-même. Un exemple, les listes de choses à faire.

- Se mettre des embuches. Exemple Victor Hugo qui a donné tous ses vêtements pour ne plus pouvoir sortir de chez lui et ainsi terminer Notre Dame de Paris

L’inverse d’ACRASIE c’est l’ENCRASIE, notre force de caractère… (no comment)

Michel Desmurget, directeur de recherche en neurosciences (Inserm): les digital natives cette légende urbaine (livre : La Fabrique du crétin digital).

Un vrai réquisitoire contre l’appellation « digital natives » (nous partageons). Il n’y a pas de modification dans le cerveau de cette génération ! Il ne s’agit pas de contester l’utilité du numérique mais de voir ce qu’ils en font, essentiellement du divertissement : un enfant de 10 ans passe 5 à 6h par jour sur des applis de divertissement. Ils sont en train de perdre le langage. La nouvelle édition du club des cinq en est un parfait exemple. Il était nécessaire de refaire une édition pour rendre les rôles des garçons et des filles moins caricaturaux, mais la langue s’est considérablement appauvrie (cf photo).

De plus, les jeunes ont perdu leur concentration (à ne pas confondre avec l’attention). Et si on touche aux 2 choses fondamentales que sont le langage et la concentration, on touche à l’intelligence… Et celle-ci mesurée en QI (ca se discute) serait en baisse, d’où le crétin digital. Cette génération ayant de grosses difficultés à trier les informations (étude a Standford), la démocratie est en danger ! Le cerveau n’est pas fait pour le numérique mais pour l’humain.

Et pour conclure ce grand vent d’optimisme, une citation

« à la marge, nous sommes en concurrence avec le sommeil. Et ça fait beaucoup de temps »

Read Hastings, Netflix.

Au fait, quand on touche au sommeil, on touche à la structure même de l’être humain…

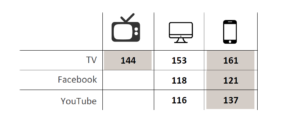

Quelques chiffres tirés de l’étude #moijeune de 20 minutes (828 répondants de 18-30 ans)

- Le sommeil est pour 78% des jeunes un plaisir mais pour 22% une perte de temps

- 57% d’entre eux serait prêts à dormir avec un appareil connecté pour apprendre en dormant (cela aussi c’est une légende urbaine !)

Albert Moukheiber, docteur en neurosciences, biais cognitifs et mutations : plongée au cœur du cerveau et des mécanismes de l’attention (livre : votre cerveau vous joue des tours, regardez cette video hallucinante !)

Ici encore le cerveau et le doute sont au premier plan.

Pour lui le doute de soi doit être une méthode d’hygiène mentale ! Nous ne pensons pas tous la même chose (même des jumeaux parfaits !) car nous n’avons pas la capacité à traiter toutes les informations qui nous viennent du réel. Notre perception est partiale (cela nous rappelle quelque chose…), notre attention est limitée et le monde est complexe.

De plus Nous confondons souvent corrélation et causalité (voir l’excellent site de Tyler Vigen sur les corrélations débiles 😊), nous fonctionnons de manière approximative. Nous avons alors de tels biais cognitifs (le moyen de nous raconter des histoires) qu’il est vital de douter de soi ! (voir ici le codex des biais cognitifs).

Alors ne faut-il pas mettre en exergue ceci

« qu’est ce que réfléchir, si ce n’est qu’une façon élégante de changer d’avis »,

autrement dit, on gagnerait à s’occuper de nos propres pensées plutôt que celles des autres et à éviter de se dire que si le monde entier était comme soi le monde serait meilleur…

Trancher c’est accepter d’être incertain !

-

Les surprises

Sydney Govou, ex-footballeur et actuel coach en entreprise, et les secrets de la concentration.

La condition physique dans le foot est une chose mais sans concentration, point de salut. Il a vu évoluer la façon d’aborder la concentration dans le football. Au départ, on leur disait de se fixer un objectif simple : exemple marque un but. Mais cet objectif simple était contre-productif car il était obsessionnel et fait sur la finalité du jeu. La méthode a évolué pour passer à un objectif de jeu et non plus à sa finalité. Par exemple, passer de marquer un but à comment récupérer le ballon. Il faut avoir des objectifs individuels qui rentrent dans le schéma de l’équipe car ce sont les interactions avec les autres qui sont la clé du succès. C’est pareil en entreprise !

Lea Alui, influenceuse

Cette jeune fille a 18 ans et 10 millions de followers sur Instagram…C’est bien une jeune fille (harcelée à l’école) venue avec sa maman, son agent et un costaud type malabar qui trouve son équilibre avec ses millions de suiveurs.

Une surprise car ce n’est pas notre monde, mais alors, pas du tout, du tout, mais nous lui souhaitons bonne chance dans sa vie, la vraie.

-

En fil rouge, des nouveautés étonnantes ou intéressantes par Ganael Bascoul et Laurent Bainier

- Roger voice : l’intelligence artificielle au service des sourds. Elle écrit sur écran un flux vocal s’une conversation téléphonique.

- Suricate-nat : détection de catastrophes naturelles en analysant le fil twitter. Le séisme en Ardèche a été détecté en 2 minutes, cela permet de faciliter le déploiement des forces de secours par géolocalisation.

- S!E: Sistema de Informacion de Emergencia qui informe les possesseurs de smartphone d’une situation d’urgence sans passer par internet mais en utilisant les ondes radio. Un tel système aurait pu être efficace a Rouen ou l’usage de nos bonnes vieilles sirènes a été inopérant les individus ne sachant que faire.

- Eternime: votre avatar immortel qui peut discuter avec vos proches…après votre décès

- Rewind : une application de podcasts géolocalisés pour découvrir l’histoire de Paris

Et il y avait plein d’autres belles choses que vous pouvez retrouver ici

MERCI MERCI MERCI MERCI 20MINUTES