Comment faire un compte rendu quand vous n’avez pu vous rendre à un évènement (à notre grand regret) ? C’est simple, il suffit de regarder les vidéos de l’évènement ! C’est ce que nous avons fait pour le Marketing Remix du 7 novembre 2019, organisé, comme tous les ans, par Viuz.

Une première cette année, les duettistes organisateurs habituels, Patrick Kervern et Andres Menajovsky, n’étaient plus qu’un solo, Andres (qui fut appelé Patrick par une intervenante, comme Patrick que l’on appelle aussi Andres !)

Merci à VIUZ de faire une conférence où les femmes sont nombreuses à prendre la parole !

Regarder des vidéos, ce n’est pas pareil que d’assister à l’évènement:

- Avec la vidéo vous ne voyez pas l’écran où l’intervenant projette sa présentation mais seulement son visage et sa voix. Cela limite les effets que les uns et les autres ont pu ou du vouloir faire.

- Une vidéo vous donne une autre liberté, celle d’arrêter de suivre et donc celle de passer à autre chose… De l’importance du « choc de l’intro » !

- La vidéo vous donne le choix aussi de ne pas voir X ou Y car, en général, vous n’apprenez rien de cette personne…

- La vidéo vous met aussi face à un contenu énorme ou la question est comment optimiser le temps et ne voir que ce qui est bien ! Impossible de répondre à cela (on a eu l’aide d’une copine qui a assisté à l’évènement !) et il ne faut surtout pas se fier au nombre de vues de chacune car pour avoir écouté certaines parmi les plus regardées et à l’opposé certaines qui recueillent peu de vues il n’y a pas de corrélation avec le contenu (selon nous) !

Alors nous vous proposons, dans cet ordre, les impressions suivantes :

- CONVAINCUE et CONVAINCANTE : Amélie Oudéa-Castera, CARREFOUR

- CASH : Jérôme Sutter, PURESSENTIEL

- ON AIME : Isabelle Bordry, RETENCY

- COURAGEUX et PERSEVERANT : Bastien Schupp, Groupe RENAULT

- TENDANCE : Arnaud Caplier, THE CONTILLERY

- FIERE DE SON JOB : Aude du Colombier, TEDIBER

- ETONNANT ET INTERESSANT : Philippe Guillaud, MATCHTUNE

- BRAVOOOOOO : Guillaume Lacroix, BRUT

-

COMMENT L’INTELLIGENCE ARTIFICIELLE TRANSFORME LE MARKETING DE CARREFOUR

Amélie Oudéa-Castera, Directrice exécutive e-commerce, data et transformation digitale | CARREFOUR |

Impression : CONVAINCUE et CONVAINCANTE

L’entreprise Carrefour (CRF)

CRF au croisement de toutes les disruptions : les transformations des règlements, des technologies des usages, la crise de confiance, l’intensité concurrentielle. La seule chose qui ne l’affecte pas, ce sont les taux négatifs (qui sont plutôt une chance !). La situation est donc complexe mais l’envie de réussir est là, pour les 380 000 employés dans le monde, parce que c’est une belle entreprise française et une marque qui a vécu et avancée avec nous tous.

Le plan CARREFOUR 2022

Un plan de transformation engagé par Alexandre Bompard, depuis janvier 2018, 5 années cela passe extrêmement vite !

Quatre grandes idées dans ce plan

- la transformation alimentaire. Rendre le mieux manger accessible à tous en respectant la planète et en ayant une juste répartition du profit le long de la chaine de valeur. Cette idée est la chose la plus importante. C’est la raison d’être de CRF.

- Réduction des coûts et hausse de la productivité

- Simplification de l’organisation et de la culture d’entreprise

- Omni-canalité entre les différents formats et le e-commerce pour une expérience fluide pour les clients CRF.

La data CRF

Quelques chiffres : 104 millions de foyer clients dans le monde qui réalisent quotidiennement 13 millions de transactions dans les 9 géographies du groupe soient 4.5 milliards de transactions à l’année… Les données sont plutôt propres et organisées car reflet du ticket de caisse. Mais pour autant CRF n’est pas aujourd’hui une entreprise « data centric », le but est qu’elle le devienne même si ce n’est pas simple ! Quelques exemples :

- Le rapport entre le ticket de caisse et la transition alimentaire. Une application vous donne, en fonction de votre ticket, la répartition de votre consommation selon les catégories de nutriments et vous fait de petites analyses de type « quel est votre nutri score » dans le mois. Une information non culpabilisante pour les clients qui peut devenir un jeu pour eux avec un incentive pour améliorer son score.

- Bâtir des ponts entre les métiers. Dans « Act for food », il y a l’engagement de retirer 100 substances controversées dans les produits proposés. Il faut être capable de passer en revue en permanence toutes les références proposées dans le monde entier et s’assurer que, par exemple, les nitrites n’y sont plus. Cela suppose d’avoir une base « d’intelligence artificielle » contenant tout ce qui est inscrit sur les étiquettes des produits plus des informations complémentaires données par les fournisseurs.

- Le ecommerce en alimentaire n’est pas rentable. Le vrai pari avec le e-commerce est d’essayer de faire rentrer des nouveaux clients par ce canal et de les faire passer dans d’autres formats Carrefour pour que l’entreprise, au global, soit gagnante.

Le Lab avec Google ?

La data chez CRF est à la fois de la data pour tous et de la data de pointe. Le lab est installé à proximité de de station F et accueille des ingénieurs et scientifiques pour la partie algorithmique la plus avancée. Exemples : amélioration des prévisions de vente ecommerce, optimisation des assortiments en fonctions des centimètres de linéaire dans les petits magasins de proximité, management du niveau de générosité sur les coupons et personnalisation de ceux-ci.

Partenariat Google

Après une phase de scepticisme au début, la méfiance a disparu car CRF a pu bâtir des expériences de shopping intéressantes avec Google. Cette dernière ayant une très grande envie de rattraper Amazon, CRF bénéficie d’expériences sur l’IA, la voix mais développe, aussi, la suite de solutions « G suite » dans l’entreprise pour casser les silos, et utilise le cloud de Google pour toute la masse de données et leur mise à disposition rapide dans le monde entier au travers d’applications innovantes, sans parler des accords commerciaux du type mettre la google home dans les hypers à des prix attractifs. CRF bénéficie à travers le lab de l’apport d’expertise de Google notamment en matière de formation des équipes. Exemple le programme Google go transform qui était la première fois ou Google transformait son programme interne vers un client externe.

AMAZON?

Une menace de tous les jours mais aussi un moteur énorme. Amazon c’est le benchmark, « le Roger Federer du ecommerce » (Amelie est une ancienne joueuse de tennis !). Mais, l’alimentation est particulière. Le ecommerce c’est souvent le fond de panier mais la proposition de valeur d’un CRF ce sont ses formats et CRF doit se positionner aussi, par exemple, sur la livraison de nourriture bonne et fraiche à l’instar d’acteur comme Frichti, Nestor pour réaliser la première promesse du plan 2022.

VISION ?

Le mot « transformation » donne l’impression d’avoir du temps, c’est faux ! Le travail de l’équipe est d’être là pour le succès de Carrefour aujourd’hui ! C’est la société dans son ensemble qui doit se réinventer et nos générations ont une responsabilité forte car les modèles sont cassés. On doit tous souhaiter que la french touch de Carrefour réussisse !

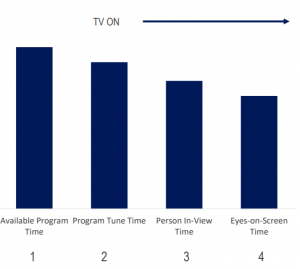

2- RETENEZ L’ATTENTION DE VOS CONSOMMATEURS : SOYEZ VU ET ENTENDU

Franck Da Silva, Directeur Commercial & Opérations, GRAVITY

Jérôme Sutter, Directeur Communication & E-Business, PURESSENTIEL

Impression : CASH

Jérôme Sutter a parlé cash et il peut parler cash pour avoir vécu, depuis un peu moins de 20 ans, tous les aspects du digital (site, media, agence, consulting…) et être maintenant directeur de la communication et du ebusiness.

Son budget de communication est faible. Il est pluri-media (presse, tv, radio, affichage, digital) et le digital représente la plus faible partie de son budget, paradoxal vu son parcours ? Non, car le pragmatisme le guide et il ne veut pas dépenser son argent pour rien ! Alors, pour des opérations digitales, la réponse la plus simple ce sont les « walled garden » qui lui permettent d’agir facilement dans 10 pays, sans que cela coûte des millions. MAIS…la nébuleuse du programmatique, les kickbacks, le bullshit en matière de langage, les indicateurs faux…. « LES WALLED GARDEN, CA NOUS SAOULE, NOUS LES ANNONCEURS » (applaudissements dans la salle). La confiance n’étant plus là, il se tourne vers des gens de confiance et des systèmes transparents comme GRAVITY. Celle-ci vend, comme le dite Jérôme Sutter, un « true view » à la française 😉. Puressentiel a réalisé une opération vidéo avec Gravity et en est très très content !

3- MESURE D’IMPACT PUBLICITAIRE PLURIMÉDIA EN MAGASIN

Isabelle Bordry, Co-fondatrice | RETENCY |

Jacques Thieck, Directeur Outils et Enablers Marketing | ORANGE |

Impression : ON AIME

Le drive to store en vrai n’est pas facile à mesurer. Il est nécessaire d’avoir un tiers de confiance pour mesurer l’effet d’une campagne sur chacune des boutiques Orange. Or, en étant dans le monde physique, pas de cookies ! La mesure doit être agnostique sur la donnée et être rigoureuse sur le mode de traitement de la donnée. D’où la sélection de Retency (une excellente solution à notre humble avis), avec ses boitiers implantés en magasin pour compter les contacts client (via leur mobile) et son mode d’anonymisation complète de la donnée (destruction de la donnée individuelle). Orange a pu mesurer, avec Retency, l’effet de 2 campagnes drive to store classique avec 2 fournisseurs différents pour voir l’impact des formats et les pénétrations atteintes par les 2 fournisseurs (campagne fibre, 5 millions d’exposition, 22 500 visiteurs exposés se sont rendus dans des magasins des Hauts de seine). « C’est le graal » selon l’annonceur.

L’expérience ne s’est pas limitée à ces campagnes mais a été continuée pour une campagne d’affichage, une de SMS, et même les vitrines de magasin Orange.

4- LA VIE D’UNE MARQUE, DU MASS MARKETING AU MASS PERSONNALISATION, 2 ANS APRÈS

Bastien Schupp, Vice President Global Customer Activation, GROUPE RENAULT

Impression : COURAGEUX et PERSEVERANT

Il était venu il y a 2 ans et revient faire le bilan de la stratégie de communication mise en place (il avait été très brillant dans son intervention ancienne et est toujours très bon aujourd’hui !)

L’idée de départ ?

90% des ressources sont investies sur la fin du cycle d’achat de la voiture. Or cela parait logique d’étaler les messages dans la durée pour construire une relation avec le consommateur. L’idée était alors de mettre 50% des moyens sur la construction de la marque et 50% sur le fin.

Le programme ?

3 piliers à ce programme

1-construire un eco-système data

2- construire différemment les contenus

3- acheter différemment les media

Tout ceci chapeauté par un essai de motivation des agences par de l’excellence créative et un programme de formation et d’accompagnement pour réaliser cette transformation.

Succès ?

OUI ! Au global, c’est un succès. L’entreprise Renault s’est transformée, les équipes marketing et communication aussi et la plupart des outils sont en place même s’il y en encore du travail de rationalisation à faire de ce coté-là. Il ne suffisait pas de transformer Renault il fallait transformer aussi les fournisseurs sur la manière de faire. Ainsi, les équipes de Publicis, d’OMD et tous les partenaires data sont sur un même plateau avec les équipes Renault. Cela a permis un gain de 40% sur le temps de création des campagnes.

MAIS il y a des choses simples ou banales que l’on a appris

- Si les équipes marcom ont bien compris, les patrons des filiales qui sont poussés sans arrêt sur les volumes au quotidien, ont beaucoup de mal à opérer ce passage du 90%/10% vers le 50%/50%. La seule solution tient dans la répétition permanente dans tous les comités de direction du message et de quantifier de prouver que c’est plus efficace. Quand un pays vous suit, il sert d’exemple pour les autres.

- Le frein principal c’est la capacité et le savoir-faire interne. Un pays qui était parfait sur la nouvelle approche pendant 6 mois, repart dans de mauvaises directions tout simplement parce qu’une personne a changé ! Il faut faire un mélange entre les nouvelles équipes et les anciennes et vérifier le travail de manière régulière

- Les modes de l’ad tech sont insupportables, tous les jours des prestataires viennent vous dire que tout ce que vous faites est nul et qu’il faut tout changer ! Il ne faut pas écouter les sirènes, il ne faut pas essayer d’être le premier dans tout ce que vous faites, il faut réduire ses ambitions, choisir ce qui marche et ce sont, bien souvent de petites choses, et ensuite persévérer !

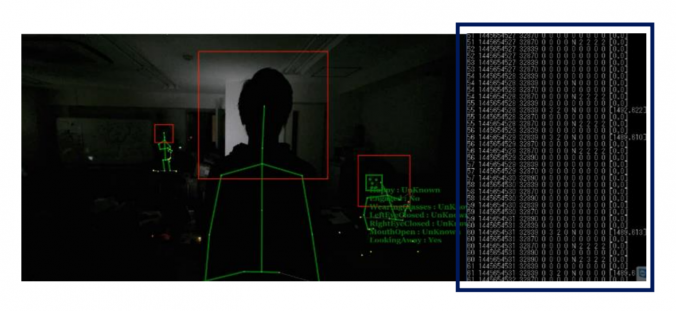

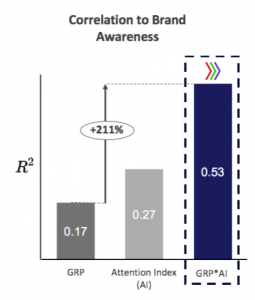

5- INTELLIGENCE ARTIFICIELLE : LES DÉCRYPTAGES DE L’ENGAGEMENT VISUEL

Arnaud Caplier, Fondateur, THE CONTILLERY

Impression : TENDANCE

On parle beaucoup de data, l’effort a été porté sur la cible, le moment, le canal et quasiment jamais sur l’optimisation des contenus qui est le plus souvent vue sous l’angle de la personnalisation et non de la qualité des contenus. Or la data permet maintenant d’arriver à cette optimisation des contenus.

En data, explosion, profusion et arrivée du machine learning. Une image aujourd’hui c’est une foultitude d’information (profondeur, luminosité, pixel, salience, ….) et on peut entamer le cycle de mesure de la relation entre les caractéristiques de l‘image sur l’action (ex image sur Instagram et like). De cette mesure, on peut ensuite aller à la prévision sous la forme d’un score par image. Une image avec un score de ou un score de 9 ont des résultats finaux extrêmement différents : conversion x 2, engagement social x 10 ou x 20.

6- TEDIBER, UNE APPROCHE DIRECT TO CONSUMER EN RUPTURE AVEC TOUS LES CODES EXISTANTS

Aude du Colombier, Co-fondatrice, TEDIBER

Impression : FIERE DE SON JOB

Création il y a 4 ans, d’une startup sur les matelas (achat important, on passe un tiers de sa vie dans un lit !) avec comme ligne directrice « remettre les clients au cœur dans tout ce que l’on fait ». L’entreprise est passée de 4 à 40 personnes avec une organisation fluide sans silo entre les fonctions. Tout le monde est actionnaire !

- Un business model totalement intégré de la fabrication d’un matelas jusqu’à la livraison à domicile pour offrir, au client, une expérience très simple et fluide en plus du rapport qualité / prix imbattable (optimisation maximale à tous les niveaux)

- Une réinvention des fondamentaux du marché en simplifiant le choix d’où un modèle unique de matelas

- La mise en transparence avec un prix juste, unique, constant toute l’année. Aucune solde n’est faite pour instaurer de la confiance et avoir une approche responsable. Ceci permet aussi d’avoir les moyens d’investir dans de la production locale, dans de la qualité produit, dans de la recherche

- La confiance passe par 100 nuits d’essai et si ça ne va pas remboursement immédiat avec récupération du produit (partenariat avec Emmaüs Défi pour ces matelas)

- La satisfaction des clients comme obsession. La pérennité de l’entreprise viendra de cela. L’équipe service client est alors la plus grosse équipe (20% des effectifs), pas de sous-traitance. Cette équipe est un actif de l’entreprise et c’est une source d’insight pour tout le reste de l’entreprise. La qualité du service client est le ressort du bouche à oreille et un vrai facteur de choix par rapport aux concurrents.

- Une évolution physique avec l’ouverture d’un magasin et bientôt d’un second même si Tediber est née sur le web et que le plus gros du business est toujours sur le web. La boutique permet l’incarnation physique et amélioration de l’expérience client.

- Une extension de gamme vers le canapé lit

- Une volonté de devenir une marque de référence

- Une minimisation de l’impact environnemental avec une production européenne et le lien avec Emmaüs

Bref, l’entrepreneuriat est une aventure passionnante, et lui permet d’avoir une vraie fierté dans le développement d’une marque et d’une activité à partir de rien. Aucun regret sur le reporting et la politique qu’elle devait faire dans les grandes entreprises où elle a travaillé (Unilever, Mc Kinsey, Google) !

7- MUSIQUE, L’INTELLIGENCE ARTIFICIELLE COMME INSPIRATION

Philippe Guillaud, CEO, MATCHTUNE (associé à André Manoukian)

Impression : ETONNANT ET INTERESSANT

Il est allé voir les entreprises qui créent les vidéos. Pour toutes, la musique est le problème !

- Il faut passer beaucoup de temps dans les grands catalogues pour faire un choix et encore faut-il trouver la bonne quand le métier d’illustrateur sonore n’existe plus.

- Comment transformer 3 minutes en 25 secondes ? des couts s’ajoutent…

- Et quand on a les 25 secondes, ca ne colle pas forcement bien avec les images

- De plus, si la musique ne plait pas, il faut tout refaire…. !

MatchTune résoudrait ces problèmes grâce à l’IA !

Pour lui, il faut d’abord comprendre la vidéo, sa structure. Ensuite on peut proposer un nombre restreint de musique et demander à l’IA d’adapter la musique à la vidéo. La machine adapte la musique pour la caler sur les x secondes de video et si ça ne plait pas, la machine propose quelque chose d’autres en un claquement de doigt !

Nous aurions aimé voir comment on fait pour mieux comprendre le processus, mais c’est intéressant !

8- “LET’S TALK ABOUT” BRUT.

Guillaume Lacroix, CEO, BRUT

Impression : BRAVOOOOOO !

BRUT est le résultat d’une intuition et d’une révolution.

- La révolution est que la conversation change la consommation media. BRUT essaye de donner du contexte a l’actualité, a la société, au monde pour démarrer une conversation pas un débat. Ce dernier ne fait que polariser les opinions (ca marche très bien sur les réseaux sociaux), cela fait du clic et n’est pas vertueux. La conversation par contre permet de bâtir des communautés. C’est la révolution

- L’intuition est venue sur les thèmes que BRUT traite. Quelques chiffres : 30 millions de personnes qui regarde BRUT chaque jour, 300 millions par mois principalement en Europe, en Inde (plus gros media en langue anglaise) et en Amérique du nord (seconde page media sur FB). 70% des spectateurs ont moins de 35 ans et ces individus, où qu’ils soient dans le monde, ont un système de valeurs qui a changé : responsabilité du pouvoir, droit des femmes, lutte contre les discriminations… tout ce qui est tourné vers des solutions pour la planète, l’environnement. L’intuition a été de choisir ces sujets là et BRUT a explosé avec la prise de conscience sur ces sujets.

Implantation.

En plus des pays pré-cités, une présence au Japon, en Chine, en Espagne, en Grande Bretagne. Dans chaque pays , la moitié de ce que BRUT distribue vient d’un autre pays. Ce qui est très bon pour le business model !

Génération globalisée.

Les variations régionales touchent la culture et le sport , le reste des valeurs est globale avec quelques nuances. Exemple en Inde, déjà le droit de la femme est compliqué, alors les LGBTQ, c’est plus dur ! Quand ils ont ouvert les USA, les jeunes américains se sont comportés de la même façon que les jeunes des autres pays, c’est pour cela qu’ils sont allés vite pour lancer la page américaine (il y a 18 mois). « Quand on s’intéresse à l’humain et que l’on montre qu’il y a des gens qui se bougent positivement à l’heure de médias classiques toujours négatifs, cela les intéresse ! »

Diffusion

Brut fait entre 1 milliard de vues par mois, 50% Facebook, 30% SNAPCHAT le reste c’est Instagram, YouTube (Ce dernier ne déclenche pas de conversation)

Vice fait 650 millions de dollars de revenu et ils ne sont pas rentables. Si Brut fait cela, ce n’est même plus de la rentabilité il peut partir sur la lune !

La pub ?

On a affaire à des générations qui adorent les marques et détestent la pub ! Du coup comment créer l’expérience publicitaire. BRUT choisit ses clients pour garder une intégrité de marque. Sur les réseaux sociaux ce qui marche c’est la preuve de ce que l’on fait, BRUT agit comme un tiers de confiance.

BRUT a levé 40 millions de dollars (Artemis, Alexandre Mars, …) pour s’étendre aux USA, assez ou pas assez ?

Editorialement BRUT fonctionne déjà très bien aux USA mais il faut convertir. BRUT est déjà archi rentable en France (pas de chiffres fournis), cela doit etre uen réalité partout. A titre d’exemple, VICE fait 650 millions de dollars de revenu et ils ne sont pas rentables. Si BRUT fait cela, ce ne serait même plus de la rentabilité mais un départ pour la lune !

L’enjeu de BRUT est l’activation des communautés pour créer un impact sur les sujets qui ont poussé les individus à se constituer en communauté. Ce défi sera dévoilé début 2020.

Intelligence Artificielle

12 personnes en techno, utilise du machine learning pour analyser son bas de catalogue et avoir de la donnée qualitative sur les générations qui les consomment. BRUT sur travaille sur l’analyse du langage naturel (NLP). Exemple, si un individu a commenté telle vidéo, le NLP permettra de lui dire qu’il y a tel aspect de cette vidéo traité dans telle autre vidéo et de lui proposer de la voir. Si on arrive à le faire on va doubler notre audience automatiquement !

Brut est unique à l’international !