Comme d’habitude un compte-rendu partiel et partial !

« Smart Data for Smart Cities / Smart Territories », tel était le thème de cette 3ème édition de Meet the Data (maison de la chimie, pas beaucoup de chauffage, 25/02/17).

Qui est derrière « Meet the Data » ?

Plein de « tronches » (ils me pardonneront !) ! Excusez du peu, Pierre Louis Lions, collège de France et Médaille Field (le Nobel de mathématiques), Jean-Michel Lasry, Normale sup, Dauphine, Emmanuel Bacry, professeur à Polytechnique (l’X)… Et aussi, une star, dans un autre genre, Dominique Delport (Global MD Havas Media Group et Président Vivendi Content).

Ils ont en commun, le rachat, il y a quelques années, par Havas Media (HM), de MFG Labs (PL Lions, H Verdier (Etalab), …) et le sponsoring de ces rencontres par HM avec Arnaud Parent (Président Havas Media Labs Global) comme co-organisateur avec Emmanuel Bacry.

- La star business, Dominique Delport

- A mi-chemin entre business et recherche

- Les interventions business

- Deux moments de bonheur intellectuel

Pour les autres, euh… je n’ai rien compris où je suis partie avant la fin, regardez le programme !

-

La star business, Dominique Delport

Le sujet était innovation et économie collaborative dans une table ronde.

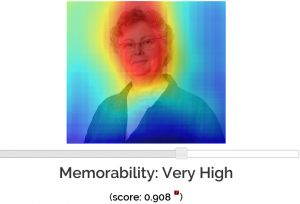

Essayer de résumer l’intervention de Dominique en une image, est osé, nous avons essayé de le faire…ça va, c’est bon, pour le début mais pas pour toute l’intervention !

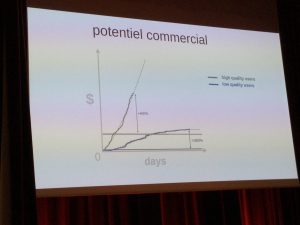

Donc, en complément de l’image ci-dessous qui dresse un portrait de l’évolution du marché avec le digital, D. Delport s’est interrogé sur la question de nos données individuelles : où est la valeur ? Les plateformes qui privatisent tout, sont dangereuses car en plus « the winner takes all », il tue ses concurrents.

Il a pris l’exemple du marché de l’Entertainement, aujourd’hui, scindé en 2 : les contenus gratuits et les contenants payants.

- La publicité est le cardinal des contenus gratuits. Qui l’emporte en ce domaine ? Le digital, qui dépasse maintenant la TV dans les investissements publicitaires. Sur ce digital, Google et Facebook emportent 100% de la croissance, un duopole sans équivalent dans l’histoire qui accumule et s’auto-renforce. Mais quand les Alexa, Siri, Google Voice, Cortona, tous les assistants virtuels sont là et où il suffit de dire « Alexa joue moi un morceau de musique », cela renvoie à comment le choix est fait pour l’individu, la prédictibilité de ses goûts, ses comportements tout ceci étant basé sur ses données, ses traces (si tracks&facts se nomme comme cela, c’est pour ça !). Ce qui s’est passé dans la finance, il y a quelques années, devient la réalité de la publicité, le programmatique, donc l’analyse de nos données.

- Dans le payant, nous sommes dans une logique de « curation » (éditer et partager les contenus les plus pertinents du Web pour une requête ou un sujet donné), de recommandation où l’impact de la donnée change encore les stratégies des maisons de disques, la détection des talents. Les maisons de disque qui ont vu leur CA être divisé par 2 en France depuis 2002, ont enregistré une croissance de 5%, l’an dernier.

De façon générale, toutes les entreprises qui ont parié sur le digital et la data, sont en croissance. Mais le ticket d’entrée est désormais presque au milliard d’individus. L’Europe, le plus grand marché du monde, doit être plus ferme pour sa souveraineté numérique.

DOMINIQUE DELPORT UN SLIDE MEET THE DATA

-

La recherche au service du business

Benjamin Devienne (Head of Data Science, Gameloft, Vivendi)

« Un moteur de recommandation de jeux videos basé sur le graphe »

(Son patron, D. Delport, a dû être fort satisfait de cette très bonne intervention. A la fin de celle-ci, Benjamin Devienne a regardé de suite la réaction de D. Delport).

Gameloft, un des leaders du jeu en ligne (3 millions de joueurs par jour), propose un très gros catalogue de jeux. La croissance de la société est conditionnée, entre autres, au fait que ses clients jouent, de plus en plus, à des jeux différents dans son catalogue. C’est une logique business. Donc, comment faire ? Comment recommander à ceux-ci, tel ou tel autre jeu.

Pour cela, il suffit de regarder les fourmis (sic !). Celles-ci cherchent toujours le meilleur chemin pour aller vers quelque chose, un point précis. Pour cela, certaines avancent à droite ou à gauche, individuellement, et laissent, au passage, des phéromones sur le chemin. Plus il y a de phéromones sur un chemin, plus celui-ci est bon, car de nombreuses fourmis l’empruntent. C’est cela, la recommandation. Le modèle utilisé par Facebook basé sur la théorie des graphes et les probabilités est dans cette lignée.

Chaque individu est connecté à un ou plusieurs jeux, et Gameloft veut identifier le chemin le plus long que son client doit emprunter dans son catalogue pour qu’il accroisse sa pratique des jeux. Gameloft cherche à maximiser la « life time value » du réseau.

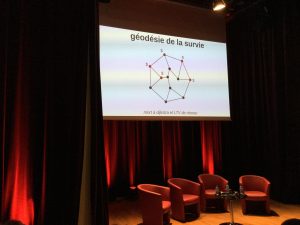

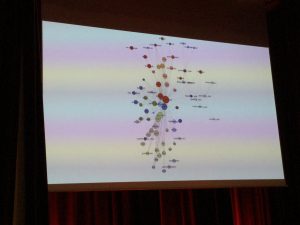

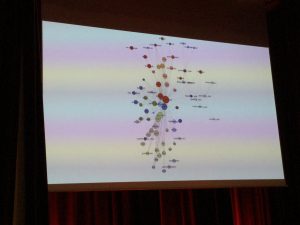

Le catalogue des jeux Gameloft peut être cartographié (volontairement flouté par l’intervenant).

Les grosses licences sont en rouge et tous les jeux sont reliés ou non entre eux.

Avec cette cartographie, Gameloft est capable de prédire à 80%, les déplacements dans le réseau.

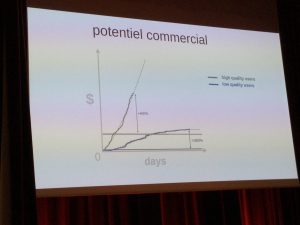

Qui dit bonne prédiction, dit croissance du profit avec une augmentation de 400% des revenus grâce à la recommandation. Il leur suffit d’une journée pour savoir si la personne restera sur le jeu grâce auquel elle est arrivée et, 3 semaines pour savoir si elle est « bougeable » ou non grâce à des recommandations qu’on lui insufflerait.

Le fait de maximiser le réseau, donne un avantage concurrentiel énorme à Gameloft.

Pour augmenter le bassin de joueur (la pénétration), ils font naturellement de la publicité et peuvent même acheter certaines « adresses » (IP, mail…), à 40 € par joueur, car des joueurs peuvent dépenser jusqu’à 150 000 où 200 000 € par an.

Envoyer des recommandations, ou les susciter, permet aussi d’augmenter la puissance de la marque et la confiance en celle-ci.

L’analyse des trous dans le graphe , dans le réseau, autorise aussi une approche stratégique du catalogue.

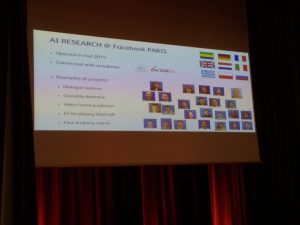

Hervé Jegou (Research Scientist, Facebook Artificial Intelligence Research)

Recherche et construction de graphes efficaces pour de grandes collections multimedia

(Une bonne présentation avec un intervenant qui a l’air adorable même si nous n’avons pas compris toutes les formules!)

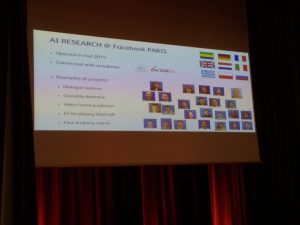

En France se trouve, un des grand centres d’Intelligence Artificielle de Facebook (FB), à Paris.

L’idée globale est d’identifier les images qui se ressemblent.

Facile ? Oh non ! Car, pour savoir si elles sont similaires, il faut être capable :

- d’identifier, de façon fiable, les composantes de l’image, ses caractéristiques,

- de les coder pour calculer des notions de distance entre images,

- de les classer en fonction de ces distances,

- pour permettre de les proposer, ensemble, selon les requêtes faites par les individus.

Et en plus, il faut faire cela quasi instantanément. Donc, un travail sur des masses d’information et de calculs en temps réel !

L’intelligence artificielle est au pouvoir et ce ne sont pas les données FB qui sont utilisées par ses chercheurs, mais des jeux de données publiques pour être à même de comparer leurs résultats.

Hervé Jegou et son équipe, ont atteint leur objectif et vont mettre en OPEN SOURCE leur méthodologie et programmes pour le bien de tous, d’ici 6 mois. Merci !

3. Les interventions business

Alain Starron (Veolia, ex TPS, pour ceux qui se souviennent de la première expérience de publicité interactive en France)

Pour Veolia, la transformation digitale, ce sont les infrastructures technologiques qui doivent permettre de fournir un bien de plus en rare, l’eau, et faire en sorte, qu’elle soit propre pour les individus.

Les objets connectés sont en première ligne pour assurer de la maintenance prédictive (réparer, changer avant que cela ne casse) via des alertes vers un centre de contrôle. Ces capteurs technologiques ne suffisent pas. L’écoute des individus permet de comprendre leurs organisations communautaires car la ville est tout autant structurée par des groupes humains que par la planification de l’organisation territoriale.

Quelques informations en bref :

- Moscou est la ville la plus embouteillée du monde (sans jeu de mot avec Veolia).

- Il y a 8 km de tuyaux à Lyon

- Mc Kinsey (The trillion-dollar challenge) a prévu que le prochain secteur impacté par le digital, seront les services publics.

Raoul Jacquand (Dassault Systèmes, Polytechnicien)

Dassault Systèmes est une société pionnière pour toutes les applications 3D.

On part forcément d’une vision de la ville de demain :

Par rapport à cette vision de la ville, Dassault Systèmes (DS) propose une plateforme où les données sont dites au service de la ville. On part de la connexion des choses ensemble (le citoyen, les services publics, le travail, …), puis la collecte des informations, leur analyse (big data car les données sont structurées ou non structurés, statiques ou temps réel, sensibles ou non, évolutives …), le design de la ville (en 3D bien sûr), la simulation, le suivi (monitoring).

Expérimentation à Rennes et, plus gros, à Singapour. Dans cette ville, 50 000 étudiants ont été équipés d’un appareil captant une multitude d’informations dans la ville de façon à nourrir la plateforme en information (expérience NSE.sg).

De façon générale, Raoul Jacquand estime que la prochaine frontière est le sous-sol, et que l’enjeu est de connecter dessus et dessous.

Le seul problème évoqué est le modèle business de tout ceci car qui paye ? les villes ? le privé ? … Où se trouve l’argent pour ce type d’approche essentielle au futur des villes.

C’était le credo tenu aussi par Pascal Terrien (EIFER, EDF), comment s’assurer que ma ville soit durable, comment attirer les investissements dans ma ville (Concurrence entre DS et EDF pour l’approche systémique)

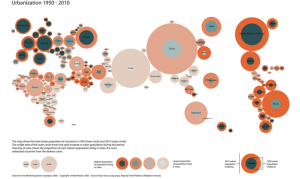

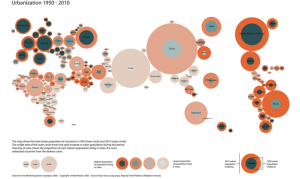

L’image ci-dessous (en cliquant vous allez sur l’image originelle), montre l’évolution de l’urbanisation par pays, entre 1050 et 2010, regardez bien, c’est la carte du monde qui se dessine.

https://www.researchgate.net/figure/273415304_fig1_Fig-2-Global-differentials-in-past-and-projected-urbanization-based-on-data-of-the

Selon lui, il faut dépasser la vision géographique des villes qui structure, actuellement, les réseaux d’énergie, pour aller vers les smart grids (optimisation de l’électricité via le digital). L’exercice est complexe, car les décisions urbaines sont à prendre pour l’heure qui suit ou pour les années futures (10 ans pour des équipements lourds).

En bref, la Chine construit chaque année une ville comme New York.

4. Deux moments de bonheur intellectuel

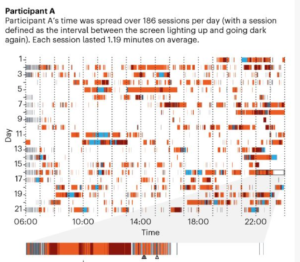

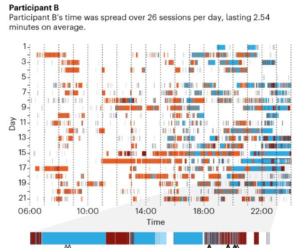

Dominique Boullier (Professeur, Chercheur Senior, Digital Humanities Institute Ecole Polytechnique Fédérale de Lausanne)

Ouvrir les boites noires du Machine Learning urbain (Un seul défaut, 10 choses importantes à la minute quand il m’en faut une par minute pour tout intégrer !)

Il est bien parti du sujet sur la ville mais nous a emmenés beaucoup plus loin sous ce prétexte.

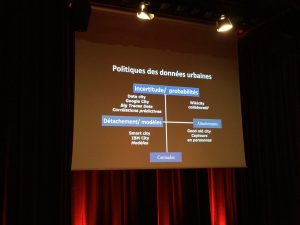

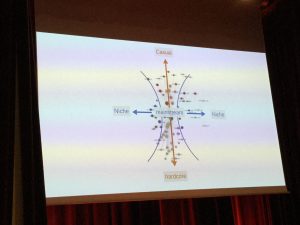

Donc la ville a évolué au travers des âges en démarrant par une ville marché, forte et souvent sacrée (moyen âge), à une ville cosmopolite (révolution industrielle), pour devenir une ville flux de données.

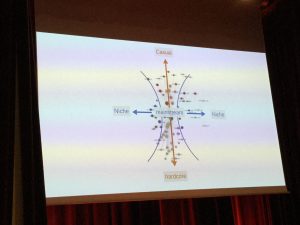

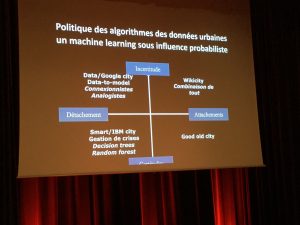

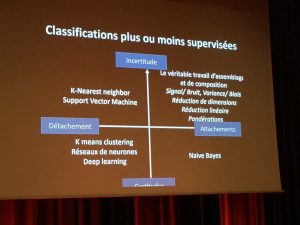

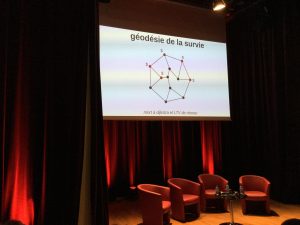

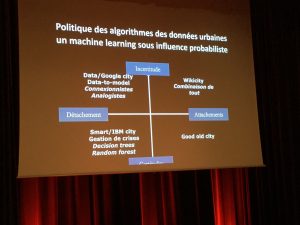

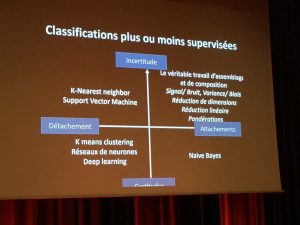

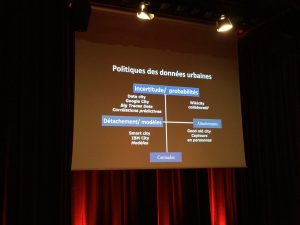

Ces flux peuvent s’organiser selon 2 axes (cf photo-ci-dessous) :

- Axe horizontal : de la certitude à l’incertitude de la donnée ville

- Axe vertical : du détachement à l’attachement à la ville

Ces 2 axes permettent de placer, d’un côté, les approches collaboratives et les relations d’affection des individus envers la ville, de l’autre, les opérateurs qui intègrent, suscitent ou analysent des données urbaines (IBM, Google…). La notion de données réelles ou prédites est là pour les séparer.

Cette approche, sous 2 angles, permet de comprendre l’influence probabiliste dans le machine learning (les méthodes qui permettent d’apprendre aux machines à réaliser des taches complexes). Elle autorise le placement, dans chaque cadran, des outils qui existent pour classer et analyser les données.

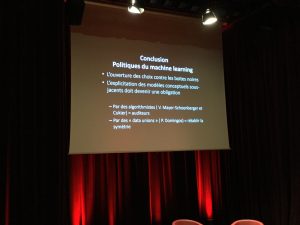

Mais, le plus souvent, ce n’est pas UNE méthode, mais un assemblage de plusieurs qui est mis en œuvre. Il constitue, très (trop) souvent, une boite noire. Celle-ci n’est blanche (ou grise) que pour ses créateurs sans qu’ils aient même bâti un modèle conceptuel sous-jacent.

Il y a un enjeu de démocratie autour de tout cela, les boites noires doivent être rendues transparentes pour que le citoyen, l’individu, profite des données et non pas subisse les données.

L’approche smart city d’IBM pour les jeux de Rio, analyse ou fournit des « image fixes » de l’homme et de la ville. Aujourd’hui, nous sommes dans une époque d’images animées, de modèle d’apprentissage, où toujours plus de capteurs fournissent toujours plus d’info sans que les résultats soient là. L’attentat de Nice en est la preuve. La présence du camion enregistrée sur les vidéos durant plusieurs jours avant l’attentat, n’a pas permis de détecter quoi que ce soit, aucune alerte. Londres intègre, dans des tableaux de bord, les données de « mood », d’humeur des londoniens et l’analyse de sentiments issue des réseaux sociaux. Cela ne sert à rien car aucune alerte n’y est reliée.

L’approche de Google, la Google city, est basée sur les connections, les flux. Cette vision permet, à d’autres sociétés, de proposer, par exemple, des services de police prédictive. Le plus souvent elles survendent les résultats de leurs modélisations de type « boite noire ». Un contre-exemple, Hunchlab qui joue la transparence dans sa méthode, c’est le machine learning responsable.

En conclusion, il faut des contrôleurs/auditeurs de ces boîtes noires et une clarté dans les modèles conceptuels sous-jacents.

Philipe Aghion, Collège de France (petit homme, plein d’énergie et d’enthousiasme), le chantre de l’innovation et de la croissance (que je résume très mal ci-dessous (désolée !)

Pour lui, seule l’innovation est le moteur de la croissance à long terme. Et pourtant, l’innovation est la destruction créatrice (pas faux !). Mais pour créer, on ne peut être seul. Nous devons nous confronter aux autres et, pratiquer, à la fois, compétition et coopération : la coopétition. Un bon exemple, le MIT et Harvard qui sont en compétition farouche pour faire venir des professeurs mais qui arrivent à s’entendre pour des travaux en commun.

Du coup les innovateurs sont dans des zones densément peuplées et la révolution digitale a changé la façon de produire des biens et services mais aussi la génération d’idée.

L’innovation n’a jamais été aussi grande que maintenant et il faut organiser l’état et la société pour qu’elle soit en mesure de vivre l’innovation.

Et pour finir, Pierre-Louis Lions a dit

« ce n’est pas la façon de faire qui est importante, on trouvera toujours, mais la question que l’on pose ! ».