Quand on consulte l’excellent site myenventnetwork.com, le constat est simple : tous les jours des événements, des conférences, des ateliers (parfois plusieurs dans la même journée) gratuits pour la majorité d’entre eux, mettent en avant un aspect du métier de la communication, du digital et des media.

C’est trop mais c’est ainsi (cf notre coup de gueule il y a 2 ans et ça n’a pas changé).

Nous sortons, de plus en plus souvent avant la fin (ce qui n’est pas poli), énervés après avoir entendu des choses déjà dites, redites, rabâchées sans aucune aspérité sans point de vue affirmé. C’est pour cela que nous n’avions rien publié sur ce blog depuis des mois. Overdose de banalités !

Aussi, quand une société vous propose de faire bouger vos neurones en vous apportant de l’intelligence scientifique, vous ne pouvez dire qu’une seule chose MERCI IPSOS !

L’idée de ces conférences à la maison de la chimie, le 26 septembre 2019 au soir, était de se réinterroger sur tous les modèles théoriques qui sous-tendent tout ce que nous faisons, faut-il les renouveler ? comment les renouveler ?

Que se passe-t-il dans notre cerveau, comment raisonne-t-on ? (Olivier Houdé, Professeur émérite Paris Descartes, laboratoire LaPsyDÉ).

Les adeptes de l’homo-economicus ont toujours mis en avant la capacité de réflexion logique de l’humain, son système algorithmique qui permet d’élaborer une pensée réfléchie, dont la fiabilité est grande mais qui nécessite du temps, des efforts pour aboutir. Son défaut ? Monopoliser notre attention (amusez-vous au jeu dans cette video). C’est le système dit 2, incarné dans les travaux de Jean Piaget. Exemples simples : lire un mot que l’on ne connait pas, changer de direction pendant un trajet habituel, calculer 19 x 46…

Daniel Kahneman (prix Nobel d’économie 2012) a démontré que le système 2 n’était pas le seul dans notre cerveau, mais qu’il en existait un autre : le système 1. C’est un système dit heuristique dont la caractéristique est d’être une pensée automatique, intuitive, avec une fiabilité correcte mais non totale et surtout une très grande rapidité. Le cerveau humain cherchant toujours à économiser sa consommation d’énergie, le système 1 est celui que nous activons le plus souvent dans nos taches quotidiennes. Des exemples ? La lecture, la conduite automobile sur un trajet habituel, des calculs simples (1+1, 2+3 …). L’apprentissage est la base de construction du système 1.

Au passage, ne pensez-pas, comme l’imaginait Piaget, qu’en passant de l’enfant à l’adulte le 1 laisse la place au 2 ! Non, suivant les sujets, les moments, l’adulte est à fond dans le système 1, aucune corrélation avec l’âge ! (Comme quoi la sagesse n’est pas l’apanage des vieux 😊)

Alors nous nous arrêtons là, avec 2 systèmes ?

Non ! Il en existe un troisième, issu des travaux d’Olivier Houdé. Ce système 3 est dit système d’inhibition qui a fonction d’arbitre, et qui nous pousse à interrompre notre processus de décision rapide (système 1) pour basculer sur la réflexion algorithmique (système 2). Le système 3 permet d’éviter les conflits entre les 2 premiers, les conflits cognitifs. Les adeptes des neurosciences le localiseront dans le cortex pré-frontal, là où se situe nos émotions et sentiments.

L’idée est alors de « cultiver » notre système 3 pour apprendre à débrancher le système 1 au profit du 2, il faut résister à notre intuition !

A quoi cela sert-il ?

Un exemple concret proposé par Brice Teinturier : les stéréotypes racistes et antisémites existent depuis longtemps (les juifs et l’argent, les juifs et le pouvoir, le lobby juif mondial…) et sont suivis par IPSOS (B Teinturier a projeté des verbatim issus des réseaux sociaux, à vomir…). La question est, pour un gouvernement par exemple, de trouver des moyens de combattre ces stéréotypes. Affirmer que ce n’est pas vrai ne sert à rien, on se heurte au mur du système 1. Comment pousser le système 3 à débrancher le 1 pour activer le 2, donc à dépasser le stéréotype pour aller à la réflexion. IPSOS a introduit dans ces questionnaires d’opinions, des mesures de nouvelles émotions relatives au doute, au regret et à la curiosité qui permettent aux pouvoirs publics de penser leurs démarchent autrement. Ces mesures sont applicables aussi au marketing.

Deuxième sujet : La modélisation de la mobilité (Olivier Bonin, Professeur, Géographe, chercheur à l’IFSTTAR au Laboratoire Ville Mobilité Transport)

Le sujet parait plus simple que l’exploration de notre cerveau et pourtant ! Comment reconstituer des flux de mobilité pour mesurer des individus qui bougent en permanence dans tous les coins. Les vieilles méthodes consistaient à reconstituer des flux en comptant des passages à des points fixes et en interrogeant des individus dans le cadre d’enquêtes. En demandant un point de départ, un point d’arrivée, un mode de déplacement et des choix d’itinéraires, il était possible de modéliser les flux. Les modèles permettaient alors d’interpoler dans le temps et l’espace, des données très partielles, lacunaires. Ceci avec plus ou moins de succès car on se limitait souvent à des heures de pointe (le matin), un jour de semaine, sans tenir compte des variabilités des activités et en étant focalisé plus sur les flux que sur les comportements des individus.

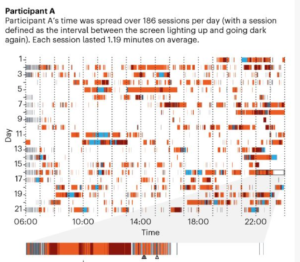

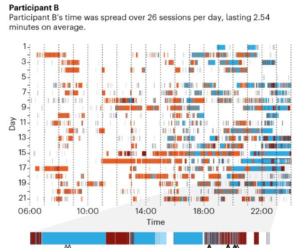

Aujourd’hui, des données sont disponibles en masse : la billétique, le GPS, les smartphones, des boîtiers dédiés… Ces données sont, de plus, relatives à un individu. Et même si elles sont moins riches sémantiquement que des enquêtes, elles apportent une densité temporelle et spatiale incomparables.

Vous y appliquez des modèles différents (on passe des modèles gravitaires aux modèles multi-agents), calculés au niveau de l’individu (qu’il soit réel ou synthétisé) et vous disposez de multiples programmes d’activité répartis entre les jours, les chaînages, les différents membres d’une famille, bref, de tout ce qui est nécessaire pour l’optimisation des trajets, des infrastructures, des horaires, … mais aussi pour la mesure d’audience de l’affichage (Outdoor, en usage maintenant…)

C’est le cas applicatif montré par (le brillant) Jean Noël Zeh (IPSOS) puisque l’entreprise a gagné l’appel d’offres de Mobimétrie (ex Affimétrie). Dans cette mesure sont intégrés les déplacements de 10 000 personnes (elles ont porté pendant 9 jours, un « meter », un boitier spécifique, précis sur la localisation GPS), des mesures déclaratives de déclarations de déplacements (smartphones), les points d’intérêts géographiques (magasin, services publics, réseaux de transports, …), toute l’open data INSEE, et des données payantes de telco ou d’autres acteurs.

Jean Noël Zeh a aussi montré 2 cas de « research for good », comme la mesure des flux dans un camp de réfugiés Rohingya au Bangladesh pour permettre d’établir des points d’eau ou des centres de soins.

Troisième intervention : le consommateur expliqué par ses neurones (Vinod Venkatraman , Professeur, Temple University).

Nous sommes repartis dans le cerveau humain ou plus exactement dans les méthodes de mesure d’effets qui existent, aujourd’hui, avec la technologie (Eye tracking, facial tracking, activité cérébrale, sudation…). Mais la chose intéressante est de les avoir relier à un impact marketing sur les ventes.

Aux méthodes nouvelles, Vinod Venkatraman a testé aussi les méthodes plus classiques d’interrogation (groupes ou questionnaires). C’est l’objet d’un article primé en 2015 à l’ARF aux USA (sur de petits échantillons…). La conclusion est bonne pour une société d’études. Que ce soient des mesures d’eye tracking, biométriques, EEG ou questionnement, chacune apporte un voire plusieurs éléments de réponse différents à l’élasticité publicitaire sur les ventes. Autrement dit, c’est en utilisant toutes les méthodes que l’on a une vision complète et pertinente. Pour avoir, nous-même, hybridées plusieurs méthodes, nous ne pouvons qu’être en accord avec cette conclusion !

En application, Katell le Coueffic a présenté le « creative lab » qui permet, en une journée, de mettre en oeuvre la plupart des méthodes indiquées et d’avoir des pistes d’optimisation sur du matériel publicitaire non finalisé. Nous supposons que ceci sera plutôt l’apanage des grands sociétés clientes.

En conclusion, une des phrases prononcées en introduction par Helen Zeitoun :

« science et études, le ticket gagnant pour ne pas dire n’importe quoi »

(combien d’entre nous devraient s’en inspirer !).