Il y a plus de 10 ans, nous avions eu l’occasion de réaliser une première en France (en Europe ?), réaliser une étude d’eye tracking sur des jeux vidéo de la plateforme Massive de Microsoft (Marie Estelle Carrasco et Ronan Bourgeois pour Microsoft Advertising, Erwan Le Page et nous-mêmes pour Havas Media, réalisation technique Ludotic). Le but était de savoir si les joueurs voyaient les publicités dans un jeu et s’ils s’en souvenaient (réponse : Oui !).

Il était temps, en octobre 2019 de se replonger dans cet univers du jeu avec la conférence « culture gaming » faite par Webedia et CB News à l’heure où l’Esport se généralise (nous y avons retrouvé Ronan Bourgeois 😉 )

Et là, vous prenez une grande claque dans la figure pour 2 raisons :

- Tout a changé et rien n’a changé

- Nous sommes « has been »

Tout a changé, rien n’a changé ?

Michelle Benzeno de Webedia a démarré son intervention par « il faut désenclaver le gaming ». Rien n’a changé en plus de 10 ans !

Mais, tout a changé, cette industrie représente, aux USA, 44 milliards de dollars (plus que l’industrie mondiale du cinéma), première industrie culturelle.

Tout et Rien n’a changé : le gaming (le jeu) a ses valeurs (bravo aux 55 gamers qui ont récolté 3.5 millions d’Euros pour l’Institut Pasteur dans le cadre de Z event) , son langage, ses codes, ses créateurs, ses œuvres.

Tout a changé : des joueurs sont devenus des créateurs (les YouTubeurs), les jeux gagnent en masse planétaire en nombre de joueurs.

Des chiffres ?

Alors, selon une étude d’opinion d’Harris Interactive réalisée pour cet événement, quelques chiffres :

- 68% de français (de quel âge ?) jouent aux jeu vidéo (smartphone, tablette, ordinateur, console)

- La moyenne d’âge est de 42 ans

- 34% sont CSP-

- 59% jouent tous les jours au presque

- Le jeu est un acte solitaire (70% préfèrent jouer en solo)

- Dans les 30% qui préfèrent jouer en multi joueurs, 10% en ligne en compétition

- 29% des français savent précisément ce qu’est l’Esport

En termes d’industrie (Jean Villedieu SNJV)?

- 250 entreprises en France

- 86% d’emplois en CDI

- 14% de femmes…

- La révolution à venir, les jeux par abonnement comme Apple Arcade

La publicité ?

Si au début, la publicité était majoritairement du display, assez vite, comme les performances étaient médiocres, la publicité était devenue du placement produit. Aujourd’hui, le modèle publicitaire est de regarder une publicité pour pouvoir avancer dans le jeu (en français dans le texte, la rewarded video). En fait, un bon jeu étant une expérience captivante, la publicité doit être un caméléon pour ne pas rompre l’expérience joueur !

Pour convaincre les annonceurs, comme d’habitude, quand on ne pratique par le media, il faut évangéliser, éduquer… (ex : comment convaincre les acheteurs en agence media d’investir en Presse alors qu’ils ne la lisent plus, et il commence à se produire la même chose pour la TV). Un argument mis en avant, l’instantanéité d’une masse connectée à un instant t (comme toujours…)

Gamification ?

Pour nous (et cela fait de nombreuses années que nous le prônons), la gamification (ludification) est l’application, à des domaines autres que les jeux vidéo (ex : les questionnaires dans une étude), des codes d’interaction nés de la pratique des jeux vidéo.

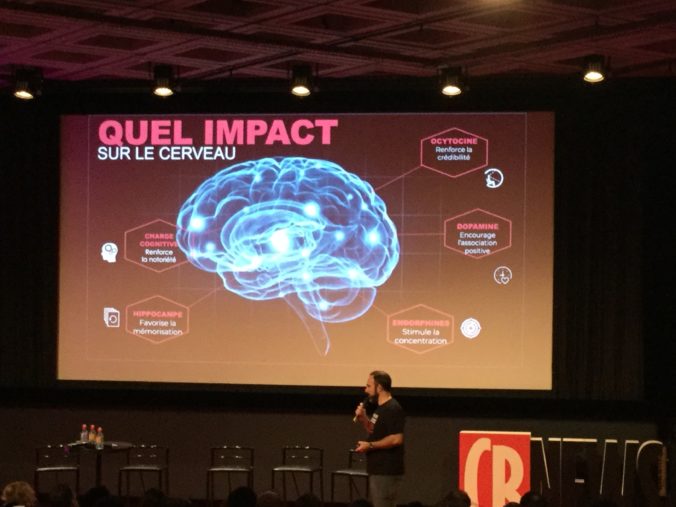

Pour Cyril Guilleminot (Gameloft), il s’agit de « l’amplification des effets d’une expérience existante en appliquant différentes techniques de motivation ce qui rend les jeux si engageants ». Et il nous a montré une belle image type neurosciences sur l’effet du jeu vidéo dans notre cerveau (cf l’image en tête de cet article) et le lien possible avec des marques (ex : le jeu vidéo active l’hippocampe donc favorise la mémorisation). Intéressant, mais nous pensons que l’on doit trouver la même chose en neuroscience pour démontrer les ravages des jeux vidéo…

Après, les mécaniques de gamification sont maintenant connues (économie comportementale, nudge…), indication des niveaux de progression, les badges, les tableaux de score, les challenges…

Esport ?

L’Esport désigne donc

« l’ensemble des pratiques permettant à des joueurs de confronter leur niveau par l’intermédiaire d’un support électronique, et essentiellement le jeu vidéo, et ce quel que soit le type de jeu ou la plateforme (ordinateur, console ou tablette) » (source : France Esport)

Le mot sport est donc trompeur ! Il ne s’agit pas des jeux liés au sport, seulement, mais tous les jeux où l’on se confronte à d’autres personnes.

Même si l’Esport n’est pas que du sport, si on le compare au sport, malgré tout, sa construction s’est faite à l’envers. Le sport est basé sur une infrastructure de clubs ou d’associations sportives locales pour remonter (du bas d’une pyramide vers le haut), vers des fédérations internationales, quand l’Esport a démarré avec des compétitions mondiales et qu’il doit descendre vers des clubs ou des associations Esportives locales (du haut de la pyramide vers le bas).

Un business avec un prix de 2.7 millions d’Euros (3 millions de $) pour le gagnant de Fortnite quand le gagnant de Rolland Garros en gagne 2.3 et le vainqueur du marathon de New York 81 000 Euros (pas de millions)…

Les émissions de jeu vidéo à la TV ont disparu au milieu des années 2000 et sont maintenant remplacées par:

- des retransmissions de compétitions d’Esport sur une chaîne de flux comme BeinSports

- des créations de chaînes de TV spécialisées (qualité broadcast) comme ES1

- des créations de chaînes en streaming comme Lestream

Si, aujourd’hui la retransmission des compétitions est gratuite, l’Esport deviendra un sport quand il y aura des droits de diffusion !

Le public du Esport est impliqué, ultra connecté et critique. Ceci a de bons mais aussi mauvais aspects, d’où une certaine réticence des marques à s’engager dans ce secteur.

Certaines ont su le faire intelligemment comme

- Louis Vuitton pour le sponsoring de la malle de la coupe de « League of Legends » (malle virtuelle).

- Le nobuild challenge du WWF dans Fortnite (encore !)

En parlant de critiques, il était intéressant de constater les réactions négatives de fans de jeu vidéo attirés par #culturegaming quant au contenu de la conférence. C’est la première fois que nous voyions du « public » (hors marabouts ou autres partisans de Daesh) intervenir si fortement dans un fil twitter consacré à un événement BtoB.

Coup de vieux ?

- Nous sommes typiquement dans la situation, quand on ne pratique pas, on ne connait pas !

- Découverte de la plateforme d’Amazon, Twitch (désolé, nous ne connaissions que Justin Tv son ancêtre !)

- des « stars » avec leur propre langue :

- Domingo (streamer, joueur, animateur et YouTubeur) qui commente des parties (30 000 à 100 000 personnes en direct suivant les formats, plus qu’un stade de foot !).

- Bruce Grannec le champion du monde du jeu FifaXXXX (donc du football), impressionnant !

- Brak2K (Mahmoud Ganassa), YouTubeur jeux vidéo qui commente des matchs d’Esport ou même, avec Bruce Grannec, de « vrais » matchs sur BeinSports

- Il n’y avait 4 personnes avec des cheveux blancs dans la salle (dont Nous) !